Auteur: Jérôme Thiébaut

On a très souvent accès en astrophysique à des données d (par exemple des spectres lumineux, des images CCD...) dont on veut extraire une quantité physique inconnue X (magnitude, masse, champ magnétique...).

Si le problème est linéaire et si on connait les lois physiques sous jacentes, on peut modéliser le problème sous la forme  , où

, où  est un vecteur contenant les données,

est un vecteur contenant les données,  est le vecteur des paramètres recherchés et

est le vecteur des paramètres recherchés et  est une matrice.

Connaissant

est une matrice.

Connaissant  on veut

on veut  , c'est ce qu'on appelle un problème inverse. Pour résoudre ce genre de problème on utilise très souvent la méthode des moindres carrés c'est à dire qu'on cherche le vecteur

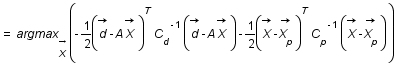

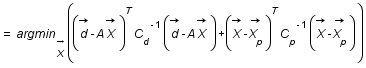

, c'est ce qu'on appelle un problème inverse. Pour résoudre ce genre de problème on utilise très souvent la méthode des moindres carrés c'est à dire qu'on cherche le vecteur  qui minimise la quantité

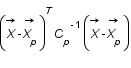

qui minimise la quantité  .C'est ce qu'on appelle un ajustement.

On se propose ici de montrer que faire des à priori gaussiens sur les distributions de probabilité de

.C'est ce qu'on appelle un ajustement.

On se propose ici de montrer que faire des à priori gaussiens sur les distributions de probabilité de  et

et  revient à utiliser la méthode des moindres carrés.

revient à utiliser la méthode des moindres carrés.

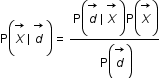

et on va chercher à déterminer la probabilité conditionnelle

et on va chercher à déterminer la probabilité conditionnelle  .

.

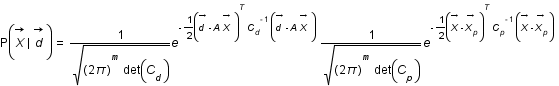

,

,  et

et  en utilisant le théorème de Bayes.

en utilisant le théorème de Bayes.

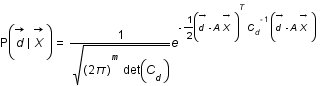

suit une loi gaussienne multivariée de matrice de variance covariance

suit une loi gaussienne multivariée de matrice de variance covariance  . Ecrire cette loi.

. Ecrire cette loi.

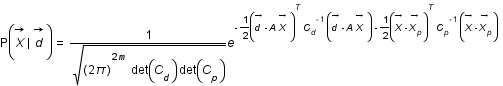

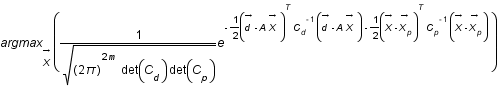

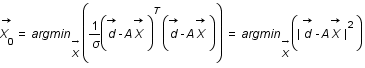

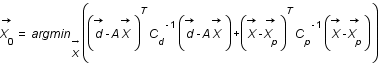

, la valeur la plus probable pour

, la valeur la plus probable pour  est

est  .

.

suit lui aussi une loi gaussienne de matrice de variance covariance

suit lui aussi une loi gaussienne de matrice de variance covariance  et de moyenne

et de moyenne  (a priori sur la solution, sur son spectre de puissance...) et que

(a priori sur la solution, sur son spectre de puissance...) et que  .

Exprimer

.

Exprimer  .

.

.

.

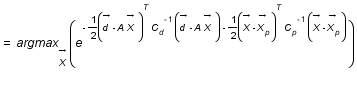

et on considère que les covariances sont nulles et les variances égales entre elles donc

et on considère que les covariances sont nulles et les variances égales entre elles donc  où

où  est la matrice identité. Que devient

est la matrice identité. Que devient  ?

?

donc le terme en

donc le terme en  disparait.

disparait.

avec m le nombre d'élement de

avec m le nombre d'élement de  .

.